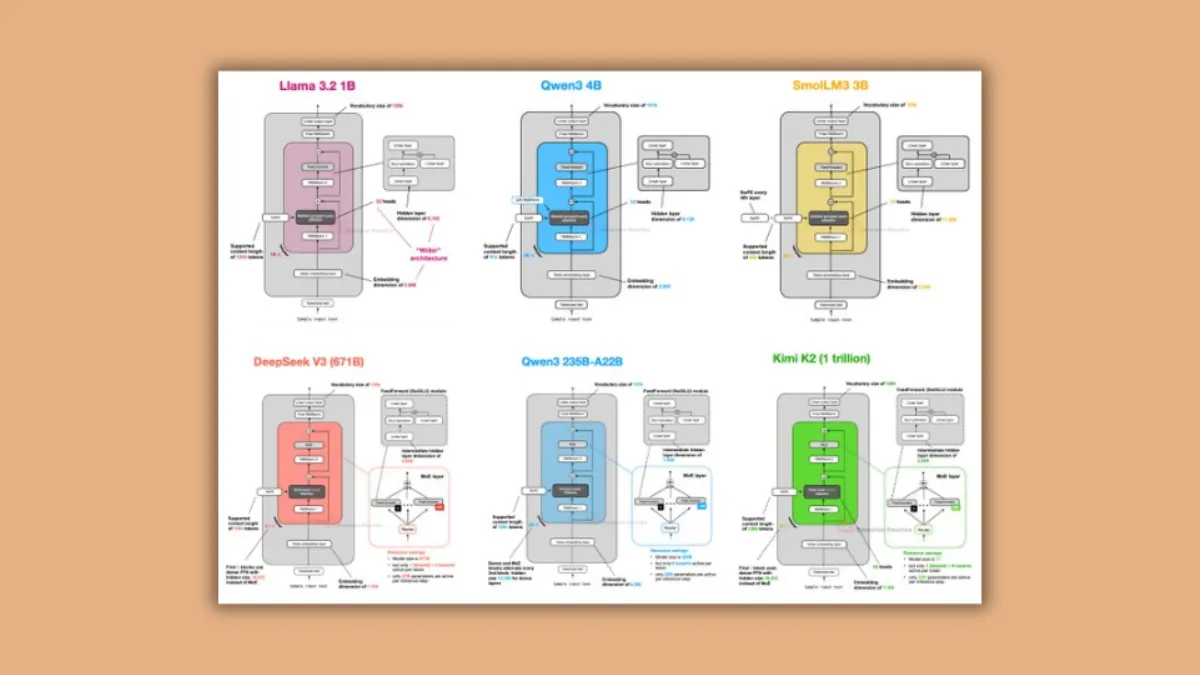

आज के समय में Large Language Models (LLMs) लगातार बदल रहे हैं। Sebastian Raschka, जो AI रिसर्च की दुनिया में एक बड़ा नाम हैं, ने हाल ही में DeepSeek V3, OLMo 2 और Llama 4 जैसे टॉप AI Models का गहराई से विश्लेषण किया। उनका यह एनालिसिस 19 जुलाई 2025 को सामने आया और इसमें उन्होंने दिखाया कि AI की दुनिया में जो बदलाव दिख रहे हैं, वे उतने क्रांतिकारी नहीं बल्कि ज्यादातर छोटे-छोटे सुधार हैं।

Sebastian ने अपने आर्टिकल में DeepSeek V3 का सबसे खास इनोवेशन “Multi-head Latent Attention (MLA)” बताया है। DeepSeek V3 में 671B parameters मौजूद हैं, लेकिन हर token के लिए केवल 37B parameters ही activate होते हैं। इसका मतलब यह है कि मॉडल ज्यादा efficient है और कम resources में भी बेहतर परफॉर्म कर सकता है। Hugging Face पर उपलब्ध DeepSeek-V3 का रिसर्च पेपर इस efficiency को validate करता है।

इसके बाद Raschka ने Google के Gemma 3 मॉडल की तुलना की, जिसमें sliding window attention का इस्तेमाल किया गया है। उनका कहना है कि इससे output की quality पर ज्यादा असर नहीं पड़ा और perplexity में भी मामूली बदलाव ही देखने को मिला। इससे यह साफ होता है कि हर नया design जरूरी नहीं कि बहुत बड़ा बदलाव लेकर आए।

अब बात करें AllenAI के OLMo 2 मॉडल की, तो इसमें RMSNorm और rotary positional embeddings का इस्तेमाल किया गया है। यह design पिछले OLMo वर्ज़न से कहीं ज्यादा stable है और training efficiency भी बेहतर हो गई है। Sebastian का मानना है कि OLMo 2 ने Llama-3.1 8B को पीछे छोड़ दिया है, जबकि OLMo 2 ने कम training FLOPs (Floating Point Operations) इस्तेमाल किए हैं। यह ओपन-सोर्स मॉडल्स के लिए एक बड़ा सरप्राइज़ है क्योंकि कम compute power में भी यह बेहतरीन output देता है।

Llama 4 पर आते हुए Raschka ने बताया कि यह मॉडल भी powerful है, लेकिन इसमें कोई ऐसा design innovation नहीं है जो DeepSeek V3 या OLMo 2 से आगे निकल सके। फिर भी Llama family का नाम और ecosystem इसे अब भी ओपन-सोर्स LLM दुनिया में एक strong contender बनाए रखता है।

Sebastian Raschka के अनुसार, AI रिसर्च में जो बदलाव हो रहे हैं वे step-by-step refinements हैं, न कि किसी तरह की अचानक आई क्रांति। DeepSeek V3 का MLA attention, OLMo 2 की RMSNorm आर्किटेक्चर और Llama 4 की consistency – ये सब यह दिखाते हैं कि AI की दिशा अभी incremental innovation पर ही ज्यादा केंद्रित है।

आखिर में सवाल यही है कि ओपन-सोर्स AI मॉडल्स की इस दौड़ में कौन आगे रहेगा। DeepSeek V3 अपने विशाल parameters और MLA innovation की वजह से efficiency दिखाता है, OLMo 2 training stability और कम FLOPs पर better performance देता है, जबकि Llama 4 अपनी reliable consistency के कारण प्रैक्टिकल दुनिया में भरोसेमंद मॉडल बना रहता है।

इस एनालिसिस से यह साफ है कि आने वाले समय में AI रिसर्च में धीरे-धीरे छोटे बदलाव होते रहेंगे, लेकिन ये छोटे बदलाव ही मिलकर AI की दिशा और भविष्य तय करेंगे।